کران چرنوف

کرانهای چرنوف نام خود را از نام هرمان چرنوف گرفتهاست که کرانی با کاهش نمایی برای محدود کردن توزیع دنباله ای (tail distribution) مجموع تعداد متغیر تصادفی میدهد. این نابربری کرانی بهتر نسبت به نامساویهای دیگر مانند نابرابری مارکف یا نابرابری چبیشف که بر اساس گشتاورهای مرتبه اول و دوم هستند به دست میدهند. اگرچه کران چرنوف لازم دارد که متغیرها مستقل باشند، شرایطی که کرانهای مارکف و چبیشف لازم نیست.

ارتباط بسیار نزدیکی بین این کران و کران هافدینگ (Hoeffding's inequality) و کران برنشتین وجود دارد.

تعریف

زمانی که تابع مولد گشتاور متغیر تصادفی X معلوم باشد، میتوانیم کرانهای خوبی برای {P{X≤a بدست آوریم.

چون کرانهای چرنوف برای همه tهای مثبت و منفی برقرار است، میتوان بهترین کران برای {P{X≥a را با استغاده از مقداری از t که (e-taM(t را حداقل میکند به دست آورد. 'کرانهای چرنوف برای متغیر تصادفی نرمال استاندارد' اگر Z متغیر تصادفی نرمال استاندارد باشد، آنگاه تابع مولد گشتاور آن M(t)=et2/2است. پس کران چرنوف برای {P{Z≥a برای هر t>0 به صورت زیر است:

حال مقدار t مثبتی که e(t2/2)-ta را حداقل میکند، مقداری است که (t2/2)-ta را حداقل میکند، یعنی t=a است؛ بنابراین برای a>0 داریم:

حال مثالی از کاربرد این کران را نشان میدهیم. فرض کنیم X1, … , Xn متغیرهای تصادفی مستقل با توزیع برنولی باشند، که هر کدام دارای احتمال p > 1/2 باشند، احتمال رخداد همزمان بیش از n/2 متغیر تصادفی برابر است با

کران چرنوف نشان میدهد که رابطهٔ بالا دارای کران پایین زیر است:

توجه کنید که برای تعدادی نمونهٔ تصادفی با توزیع برنولی داریم

با استفاده از نتایج کران چرنوف (در ادامه) میتوان نشان داد که

باید توجه کرد که با توجه به خواستههای مسئله میتوان از فرمهای مختلفی از کران چرنوف استفاده کرد.

یک مثال جالب

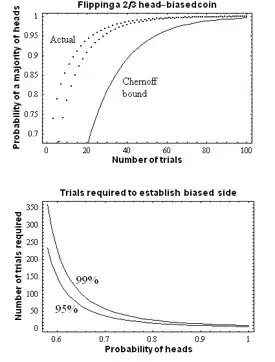

تصور کنید سکه ای اریب داریم (یعنی احتمال رو و پشت با هم یکسان نباشند). اکنون سؤال این است که چطور میتوان سمتی که دارای احتمال بیشتری است را پیدا؟ جواب ساده این است که سکه را بی نهایب بار پرتاب میکنیم و با حساب کردن احتمال هر سمت، آنی که احتمال بیشتری دارد را انتخاب میکنیم؛ ولی در عمل چنین کاری انکانپذیر نیست. چگونه میتوان با تعداد پرتاپهای محدود، با احتمالی خوب، حدسی در مورد احتمال سمتی که دارای احتمال رو/پشت بیشتر زد؟

فرض کنیم که متغیری تصادفی باشد که تعیین میکند که آیا پرتاب i-ام رو آمدهاست یا خیر. فرض کنیم بخواهیم مطمئن باشیم که احتمال اینکه سمتی اشتباه را انتخاب کنیم ε باشد. با بازی با رابطهٔ بالا داریم:

که حداقل تعداد آزمایش را نشان میدهد. به عنوان مثال اگر احتمال موفقیت p = .۶ باشد، اگر بخواهیم با اطمینان ۹۵ درصد، یعنی قضاوت کنیم، باید حداقل بار پرتاب انجام دهیم.

یکی از کاربردهای کران چرنوف در بررسی الگوریتمهای تصادفی (یا در طراحی و بررسی مدلهای محاسباتی مانند رایانه کوانتومی) برای بررسی حداقل تعداد آزمایشهای برای رسیدن به درجهٔ مشخصی از اطمینان است.

اثبات نابرابری چرنوف

با استفاده از نابرابری مارکف داریم به ازای هر t > 0:

با داشتن فرض استقلال بین متغیرها داریم:

به صورتی مشابه:

و

تئوری برای مجموع متغیرهای تصادفی

تئوری ذیل تئوری چرنوف-هافدینگ نام دارد. فرش کنید متغیرهای تصادفی مستقل با توزیع یکسان باشند. فرض کنیم , و . در اینصورت

و

که در آن

دیورژانس کالبک-لیبلر بین متغیرهای تصادفی و است. در صورتی که در اینصورت

تئوری برای حالتهای خاص

در حالتهای خاص میتوان از تقارن متغیرها در مسئله استفاده کرد و کران بهتری بدست آورد.

جستارهای وابسته

منابع

- مبانی احتمال، نویسنده: شلدون راس، مترجم دکتر احمد پارسیان و علی همدانی، ویرایش هشتم، فصل ۸، بخش ۵.

- Chernoff، H. (۱۹۵۲). «A Measure of Asymptotic Efficiency for Tests of a Hypothesis Based on the sum of Observations». Annals of Mathematical Statistics. ۲۳ (۴): ۴۹۳&ndash, ۵۰۷. doi:10.1214/aoms/1177729330. MR 0057518. Zbl 0048.11804. جیاستور ۲۲۳۶۵۷۶.

- Hoeffding، W. (۱۹۶۳). «Probability Inequalities for Sums of Bounded Random Variables». Journal of the American Statistical Association. ۵۸ (۳۰۱): ۱۳–۳۰. doi:10.2307/2282952. جیاستور ۲۲۸۲۹۵۲.

- Chernoff، H. (۱۹۸۱). «A Note on an Inequality Involving the Normal Distribution». Annals of Probability. ۹ (۳): ۵۳۳. doi:10.1214/aop/1176994428. MR 0614640. Zbl 0457.60014. جیاستور ۲۲۴۳۵۴۱.

- Hagerup، T. (۱۹۹۰). «A guided tour of Chernoff bounds». Information Processing Letters. ۳۳ (۶): ۳۰۵. doi:10.1016/0020-0190(90)90214-I.

- Ahlswede، R.؛ Winter، A. (۲۰۰۳). «Strong Converse for Identification via Quantum Channels». IEEE Transactions on Information Theory. ۴۸ (۳): ۵۶۹–۵۷۹. arXiv:quant-ph/0012127.

- Mitzenmacher، M.؛ Upfal، E. (۲۰۰۵). Probability and Computing: Randomized Algorithms and Probabilistic Analysis. شابک ۹۷۸-۰-۵۲۱-۸۳۵۴۰-۴.

- Nielsen, F. (2011). "Chernoff information of exponential families". arXiv:1102.2684 [cs.IT].

- Sinclair، Alistair. «Class notes for the course "Randomness and Computation" given Fall 2011» (PDF). بایگانیشده از اصلی (PDF) در ۳۱ اکتبر ۲۰۱۴. دریافتشده در ۲۶ دسامبر ۲۰۱۲.